В целом современные ИИ-агенты в кибербезопасности представляют собой сложные мультиагентные системы, обладающие памятью и способностью учитывать предыдущие инциденты для повышения эффективности защиты. За счет использования мультимодальных языковых моделей такие агенты способны анализировать информацию в различных форматах - текстовые логи, изображения экранов, аудиозаписи и видеопотоки. Это позволяет выявлять угрозы, которые остаются недоступными для традиционных систем, ориентированных на анализ однотипных данных.

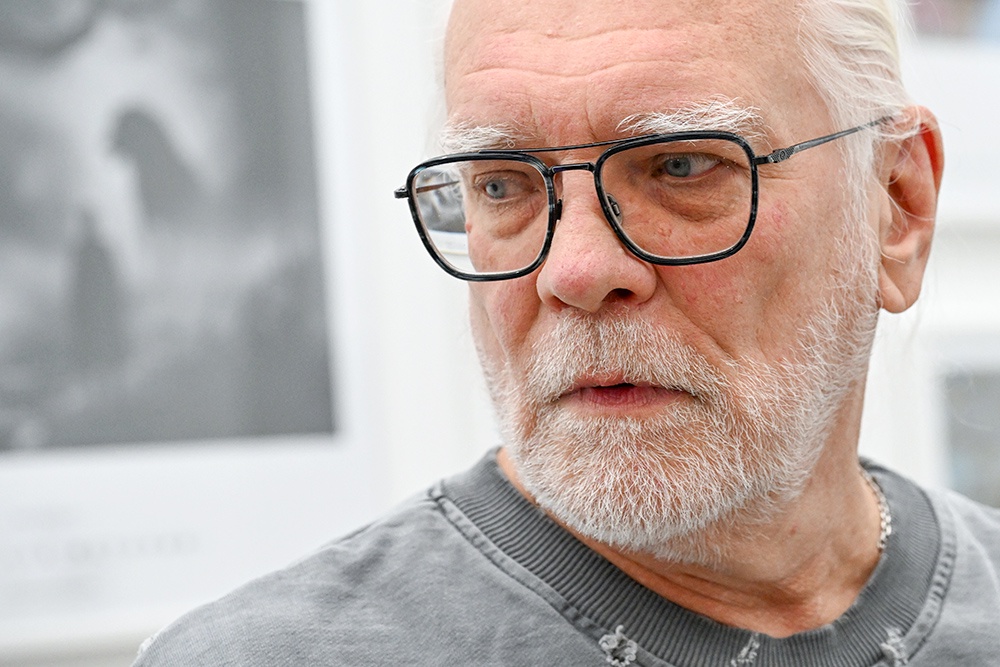

Ильдар Исмагилов, руководитель центра компетенций интеллектуальной автоматизации Innostage, рассказал, что ИИ-агенты трансформируют подход к кибербезопасности и перестают быть просто "виртуальными ассистентами". Их начинают использовать для выполнения части задач, которые ранее решались исключительно людьми, в частности аналитиками SOC (Центра мониторинга информационной безопасности). Речь идет об автоматизации обнаружения угроз за счет анализа больших массивов данных и выявления аномалий в режиме реального времени.

"Одной из ключевых функций становится автоматизация реагирования на инциденты. ИИ-агенты способны оперативно изолировать скомпрометированные системы и блокировать вредоносный трафик без ожидания вмешательства человека, что критично в условиях ограниченного времени на принятие решений", - объясняет эксперт.

Кроме того, ИИ-агенты помогают формировать гипотезы, собирать коррелированные данные и автоматизировать аналитические цепочки, позволяя быстрее выявлять скрытые угрозы. В центрах обработки инцидентов безопасности такие решения эволюционируют в контекстно-ориентированные и целеустремленные системы, способные самостоятельно сортировать инциденты, проводить первичное расследование и инициировать ответные меры.

"Самая большая польза агентов в продвинутой обработке уведомлений систем безопасности. Агенты могут разобраться в сути, запросить дополнительный контекст, вынести предварительный вердикт и даже отреагировать на критическую угрозу: заблокировать подозрительные IP-адреса и изолировать зараженные узлы сети", - говорит ML-директор Positive Technologies Андрей Кузнецов.

При этом для полноценного внедрения ИИ-агентов необходимо учитывать специфику конкретной инфраструктуры, проводить дообучение моделей и реализовывать дополнительные меры защиты.

Исмагилов отмечает, что к числу практических сценариев применения ИИ-агентов в ИБ относятся обнаружение угроз, анализ и автоматическое реагирование на инциденты, проактивный поиск угроз, поддержка принятия решений и автоматизация отчетности. За счет наличия долговременной памяти агенты могут учитывать предыдущие кейсы и извлекать из них уроки. Мультиагентные архитектуры позволяют агрегировать данные от узкоспециализированных агентов, выявлять скрытые закономерности и формировать целостную картину происходящего.

Он добавляет, что автоматизация рутинных операций - таких как раннее обнаружение, классификация и триаж инцидентов - позволяет существенно сократить среднее время обнаружения (MTTD) и реагирования (MTTR), высвобождая ресурсы команд для решения более сложных и стратегических задач.

При этом в России массового внедрения ИИ-агентов в информационную безопасность пока не наблюдается. Артем Артамонов, ведущий инженер StormWall, указывает, что на данный момент в основном речь идет о пилотных проектах и точечных решениях.

"В некоторых российских SOC применяют ИИ для конкретных рутинных операций. Например, для анализа и расшифровки обфусцированных скриптов, для автоматизации создания правил обнаружения угроз или для работы с тикетами - ИИ-агент мониторит обращения, иногда отвечает сам и может даже предлагать закрыть некоторые задачи", - говорит Артамонов.

Кузнецов поясняет, что широкому внедрению ИИ-агентов в кибербезопасность мешает то, что агенты работают на больших языковых моделях (LLM), которые требуют либо дорогостоящих серверов, либо передачи данных внешним сервисам. Сфера ИБ и так является довольно сильно зарегулированной, а новые инициативы вроде еще сильнее ограничивают возможности применения ИИ для защиты, указывает эксперт.

Также массовому внедрению мешает высокая стоимость разметки данных. "Даже если удалось собрать данные, то найти специалистов способных качественно разметить датасеты "атака/не атака" - сложная задача. В этой части мы чем-то похожи на медицинский домен, где, например, предварительный диагноз, определенный ИИ, в последствии должен верифицировать профильный врач", - говорит Кузнецов.

Также сами ИБ-специалисты сегодня все чаще используют ИИ в личных целях - для автоматизации своей рутины. Например, просят модель проверить конфигурацию, распарсить сложный файл или проанализировать длинный лог. Артамонов отмечает, что правильно сформулированная задача экономит время специалиста с часа до нескольких минут, это и есть реальная польза здесь и сейчас - не замена человека, а усиление его возможностей.

При этом такие внедрения могут привести и к серьезным рискам для данных. Артамонов отмечает, что ключевой риск - это слепое доверие ИИ. Любая ИИ-модель - это ПО, и оно может быть уязвимым. В частности, всегда есть вероятность, что злоумышленники будут использовать методы "ослепления" ИИ-агента. И для таких атак киберпреступники тоже могут использовать ИИ.

Еще к числу ключевых угроз относятся избыточные права доступа, при которых агент получает возможность работать с внутренними документами, перепиской или HR-данными, а также риск утечки через вывод модели, когда фрагменты конфиденциальной информации могут непреднамеренно появляться в ответах или сохраняться в логах.

"Отдельную категорию рисков составляют атаки через запросы, позволяющие злоумышленникам заставить агента выполнить нежелательные действия или раскрыть чувствительные данные. В случае компрометации ИИ-компонента атакующий фактически получает "цифрового сотрудника" с доступом к корпоративным системам", - рассказал Исмагилов.

Поэтому для снижения подобных рисков необходим комплексный подход. В частности, важно внедрение специализированных защитных механизмов, которые анализируют и контролируют входящие запросы и выходные ответы ИИ, предотвращая утечки и злоупотребления. Такие решения выступают защитным слоем между ИИ-агентами и внутренними системами.

"Дополнительное значение имеет соблюдение регуляторных требований, включая рекомендации ФСТЭК России. Так, приказ ФСТЭК № 117 вводит требования к обеспечению безопасности систем на базе ИИ, включая контроль доступа, журналирование событий и меры по предотвращению утечек. Наконец, критически важным остаётся применение принципов минимальных привилегий, при которых ИИ-агенты получают только те права, которые необходимы для выполнения конкретных задач", - заключает Исмагилов.